Die stille Vollbremsung: Weshalb fehlende Datendurchgängigkeit die Wertschöpfung gefährdet

Es ist ein Paradoxon der modernen Wirtschaft. Unternehmen investieren Milliarden in digitale Transformation, Analytics und Künstliche Intelligenz, doch die erwarteten Produktivitätssprünge bleiben oft aus. Wenn eine KI Strategie so wirkt, als könnte sie auf jedes andere Unternehmen angewendet werden, indem einfach das Logo auf dem Foliendeck geändert wird, handelt es sich nicht um eine Strategie. Es ist vielmehr eine Reihe taktischer Maßnahmen. Der wahre Grund für die Stagnation liegt tiefer und ist oft schmerzhaft banal. Die Daten fließen nicht, sondern sie stocken.

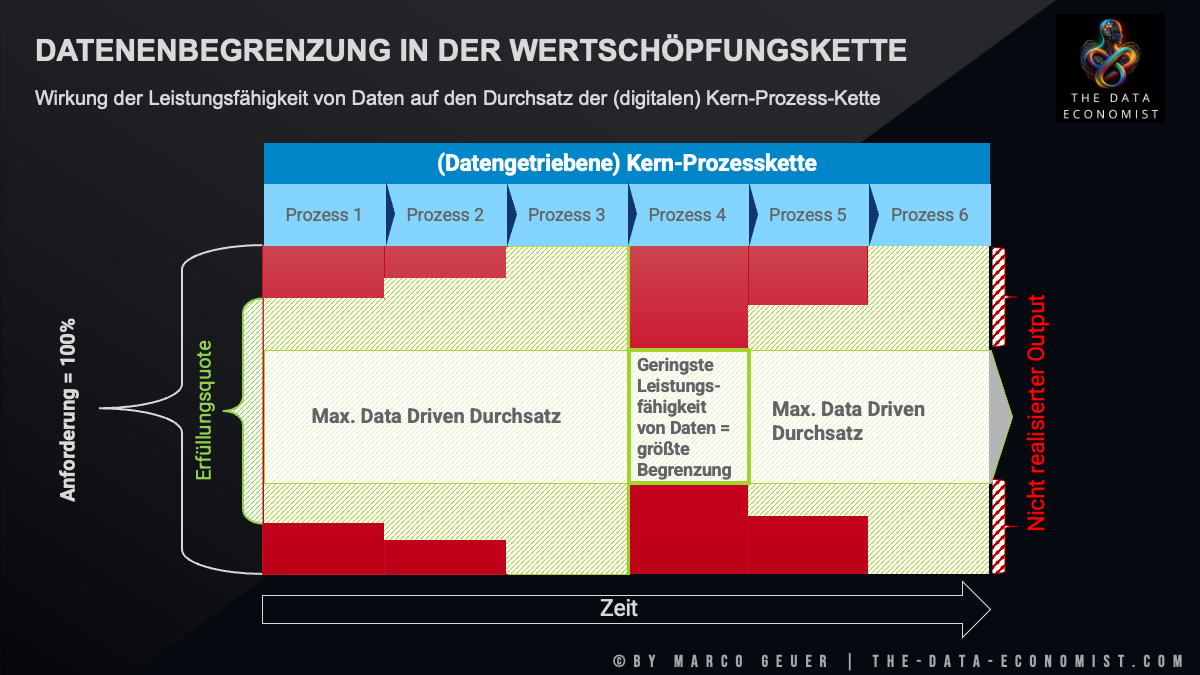

Daten sind in vielen Organisationen zum größten Engpass der Wertschöpfungskette geworden, ohne dass dies auf strategischer Ebene bemerkt wird. Es mangelt nicht an Speicherkapazität, sondern es dominieren Medienbrüche, redundante Korrekturschleifen und eine fundamentale Unfähigkeit, Informationen nahtlos von der Quelle bis zur Entscheidung zu transportieren. Es ist notwendig, Daten nicht mehr als IT Nebenprodukt, sondern als das zentrale Fließband der Wertschöpfung zu betrachten.

Die verborgene Fabrik der Fehlerkorrektur

In der klassischen Produktion wäre ein defektes Fließband, das halbfertige Produkte abwirft, ein sofortiger Notfall. In der Datenwelt ist dieser Zustand jedoch Alltag. Ressourcen werden gebunden, um dieselben fehlerhaften Daten an verschiedenen Stellen manuell zu korrigieren. Dies stellt eine Hidden Factory dar, eine verborgene Fabrik unproduktiver Arbeit, die Kosten verursacht, aber keinen Wert schafft.

Datenqualität ist keine revolutionäre Idee, die erst mit Chatbots aufkam, sondern sie ist seit Jahrzehnten die Basis guter Entscheidungen. Dennoch wird Datenmanagement häufig vernachlässigt. Man weiß um die Relevanz, nimmt sich Besserung vor, fällt aber in alte Muster zurück. Das Resultat sind Medienbrüche, welche die Integrität der Informationen zerstören. Wenn Daten nicht durchgängig sind, wird Analytics zur Archäologie. Man gräbt nach der Wahrheit, anstatt mit ihr zu arbeiten. Wahre Effizienz entsteht erst, wenn das Bestehende nicht nur punktuell optimiert wird. Es bedarf des Mutes, eine systemische und dateninspirierte Transformation anzustoßen, also den Wechsel von Data to Insights zu Data to Transform.

Verfügbarkeit ist nicht gleich Durchgängigkeit

Ein weit verbreiteter Irrtum ist die Gleichsetzung von Data Availability mit Datendurchgängigkeit. Verfügbarkeit gleicht einem Lagerhaus voller Teile, wohingegen Durchgängigkeit die Just in Time Lieferung ans Montageband darstellt. Verfügbarkeit ist der Enabler, aber erst die Durchgängigkeit schafft den ökonomischen Wert. Je mehr Mitarbeitende das Ursache und Wirkungsgefüge in den Daten verstehen, desto klarer wird, wie Informationen fließen müssen und wo künstliche Barrieren den Outcome behindern.

Hier wird Data Literacy zur entscheidenden Ressource. Es geht nicht nur darum, Dashboards zu lesen, sondern Verantwortung für die Datenqualität an der Quelle zu übernehmen. Datenkompetenz entsteht nicht durch Technologie, sondern durch organisationales Ermöglichen. Wenn verstanden wird, dass ein Fehler bei der Dateneingabe am Anfang der Kette eine KI Entscheidung am Ende der Kette korrumpiert, ändert sich das Bewusstsein. Ohne dieses Verständnis bleiben Dateninitiativen oft wirkungslos.

Die Industrialisierung der Intelligenz durch Standards

Der Grund für das Scheitern vieler KI Projekte und Analytics Vorhaben in der Skalierung liegt oft in der handwerklichen Datenverarbeitung, während industrielle Standards benötigt würden. Datendurchgängigkeit erfordert Standardisierung. Um Digitalisierung, Analytics und KI wirklich zu verschmelzen, wird eine Industrialisierung der Daten benötigt. Dies gleicht einem Qualitätsmanagement in der Industrie, das sicherstellt, dass täglich tausende Datenprodukte in gleichbleibender Qualität ausgeliefert werden.

Dies erfordert Governance nicht als bürokratisches Hindernis, sondern als Enabler. Ein Data Governance Framework wie das Data Management Model 5.0 schafft die nötigen Leitplanken. Es definiert Standards, die sicherstellen, dass Daten systemübergreifend interpretierbar bleiben. Wenn KI als grundlegende strategische Fähigkeit begriffen wird, die Produkt, Marke und Regulierung berührt, dann sind gemeinsame Standards das Fundament. Ohne diese Standards, die eine technische und semantische Interoperabilität gewährleisten, bleiben KI Modelle oft isoliert.

Konvergenz der Disziplinen

Es ist ein Wendepunkt erreicht, an dem Digitalisierung, Analytics und KI zusammenwachsen. Diese Konvergenz funktioniert jedoch nur reibungslos, wenn Hindernisse beseitigt werden. Erfolgreiche Unternehmen fragen nicht mehr, wie KI gemacht wird, sondern wie das Geschäft besser, schneller und anders gestaltet werden kann. Die Antwort liegt in der Beseitigung der Barrieren im Datenfluss. Eine hohe Datendurchgängigkeit reduziert den Aufwand für Datenaufbereitung und erhöht den Output. Sie unterscheidet Unternehmen, die rückwärtsgewandt reparieren, von jenen, die vorwärtsgewandt agieren.

Fazit und Handlungsempfehlungen

Zur Beseitigung der Engpässe sind folgende Schritte notwendig:

-

Identifikation der Brüche: Bevor neue Tools eingeführt werden, muss analysiert werden, wo Datenflüsse abreißen. Oft sind manuell versendete Tabellenkalkulationen ein Indikator für Engpässe.

-

Governance als Service: Standards sollten die Arbeit erleichtern. Konzepte wie Minimum Viable Governance helfen, schnell Werte zu schaffen, ohne die Organisation zu lähmen.

-

Investition in Kompetenz: Teams müssen im Verständnis der Datenflüsse geschult werden. Es empfiehlt sich, die Rollen von Data Accountables und Data Responsibles in den Fachbereichen zu stärken, um Verantwortung und Qualität an der Quelle zu sichern.

-

Messung von Time to Data: Die Geschwindigkeit und Qualität, mit der Daten durch die Organisation fließen, sollte als relevanter Indikator für das Management etabliert werden.

Daten bilden das Nervensystem eines Unternehmens. Wenn die Signale nicht durchkommen, ist die Handlungsfähigkeit eingeschränkt. Wird für Durchgängigkeit gesorgt, kann die Intelligenz der Systeme ihr Potenzial entfalten.

Weitere interessante Artikel:

- Advisory | Impulse Talks | Trainings

- Warum Verantwortung alleine nichts bewirkt – Befähigung als Schlüssel für eine dateninspirierte Zukunft

- Daten- und KI-Strategien: Warum Unternehmen ihre strategische Verantwortung nicht delegieren sollten

- So verändert der smarte Einsatz von KI den Umgang mit Wissen im Unternehmen

- Messpunkte vs. KPIs – Ein entscheidender Unterschied

- Die neue Wertschöpfungslogik im Datenzeitalter: Wie Data Governance den Weg von Aufwand zu Wirkung radikal verändert

Data Quality Management, Data Governance, Data Strategy, Data Management, Data Inspired Culture, Decision Intelligence, Datenindustrialisierung, Datendurchsatz

- Geändert am .

- Aufrufe: 1275